梦晨 发自 凹非寺白丝 跳蛋

Transformer自问世后就大放异彩,但有个小差错一直没惩办:

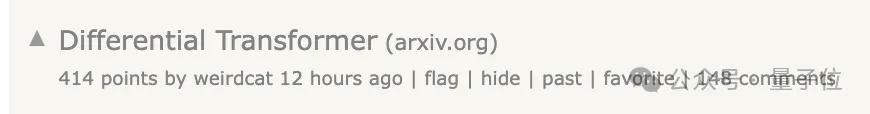

总爱把贯注力放在不关系的履行上,也即是信噪比低。

当今微软亚研院、清华团队动手,提倡全新纠正版Differential Transformer,专治这个老差错,引起热议。

论文中先容,举座念念路访佛差分放大电路或降噪耳机,用两个信号的差值来滤除共模噪声。

具体到在言语模子中,要是句子很长,只好少数token会委果影响现时token的含义。而贯注力机制允许每两个词之间产生交互,其中就包含多数噪声了。

团队提倡的递次是在贯注力层中增多一个Softmax,然后两个Softmax作念减法。

这一减,噪消息息就被大幅对消,让贯注力更集会在关系履行上。

言语建模任务上的一系列实验达成表露,仅需约65%的模子大小或教师tokens,DIFF Transformer就能达到与传统Transformer极度的性能。

新架构在长凹凸文建模、枢纽信息检索、减少幻觉、提高凹凸文体习智力以及减少激活极端值等各项主义中,遍及优于Transformer架构。

论文上传到arXiv平台后,有不少学者到弹幕版alphaXiv划线发问。一作Tianzhu Ye正绝赞在线答疑中。

差分Transformer

与传统Tranformer比拟,DIFF Transformer保抓宏不雅架构不变,主要区别在于用差分贯注力替换传统softmax贯注力。

此外还弃取了LLaMA系列中的一些纠正,如pre-RMSNorm归一化和SwiGLU激活函数。

在差分贯注力模块中,需要先给Q和K分红两个组,然后区分计较softmax。

第二组乘了一个标量λ,是可学习的参数,在归拢层的贯注力头之间分享。

λ的引入是为了在差分操作中均衡两组贯注力的孝敬,使得差分贯注力机制大约更好地安妥不同的任务需乞降数据散播。

接下来是一系列实验达成。

言语建模评估

在1T tokens上教师3B大小的DIFF Transformer,投诚 StableLM-3B-4E1T的配方,在各式卑劣任务中与已往教师高超的Transformer模子比拟发达出上风。

可膨胀性评估

只需约65%的模子参数或教师tokens来匹配Transformer的性能。

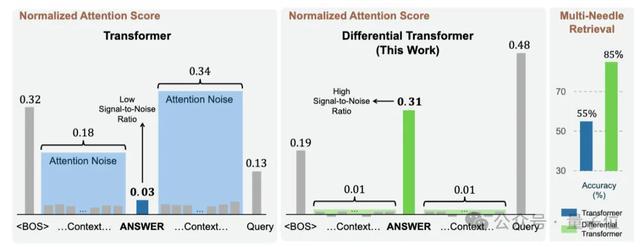

长凹凸文智力评估

在非常1.5B tokens上教师3B大小的DIFF Transformer,膨胀凹凸文长度至64k。

跟着凹凸文长度增多,累计平均负对数似然(NLL)抓续缩小,而且比传统Transformer的NLL值更低。

标明DIFF Transformer不错有用讹诈无间增多的凹凸文。

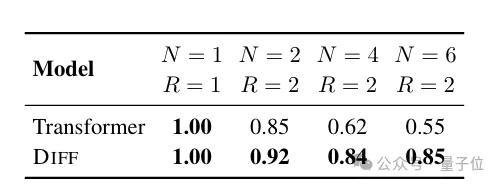

枢纽信息检索智力评估

也即是多个“针”的大海捞针探员,成就不同的凹凸文长度(4K和64K)来模拟不同复杂进程的信息检索场景。

在4K凹凸文长度下,跟着插入 “针” 数目和查询数目的增多,DIFF Transformer的准确率保抓安闲,而Transformer 的准确率权臣下落。

在64K凹凸文长度下,DIFF Transformer在不同谜底针深度(即枢纽信息在长凹凸文中的位置)和凹凸文长度下都能保抓安闲性能,且在枢纽信息位于凹凸文前半部分时上风彰着。

极度是当枢纽信息位于25%深度时,DIFF Transformer比Transformer的准确率提高了 76%。

凹凸文体习智力评估

分为两个角度来评估,区分是种种分内类和凹凸文体习的端庄性。

种种分内类任务,相通使用64K凹凸文长度的3B参数模子,DIFF Transformer的准确率历久高于Transformer,晋升幅度从5.2%到21.6%不等

凹凸文体习端庄性弃取胪列顺次任务,DIFF Transformer的达成方差远小于传统Transformer。

凹凸文幻觉评估

主要神气输入中包含正确事实,但模子仍然无法产生准确输出的情况。

将模子输出与ground-truth沿路发给GPT-4o,让GPT-4o来判断是否存在幻觉,此前探员标明GPT-4o与东说念主类评判达成一致率较高,相对可靠。

在不同数据集上DIFF Transformer的准确率更高,幻觉更少。

激活极端值分析

Transformer中的激活极端值,导致模子在教师和推理经由中难以量化。

探员比较了贯注力logits和掩藏情状两种激活类型下的最大激活值,DIFF Transformer都发达出更低的顶部激活值,即产生更少的激活极端值。

在对贯注力logits进行量化实验时,DIFF Transformer在缩小比特宽度量化时仍能保抓较高性能,而Transformer在6-bi 量化时准确性权臣下落。

4-bit的DIFF Transformer能达到与6-bit的Transformer极度的准确性,且比4-bit的Transformer准确率提高约 25%。

代码已开源, 降噪耳机类比引热议

关于面前读者的疑问,作家已作念出几点文告

问题1:Diff Transformer与每个贯注力头温度可学习的递次有什么不同?与门控贯注力对比何如?

作家回话在实验中,可学习温度成果不大。而本文递次是门控贯注力的纠正。

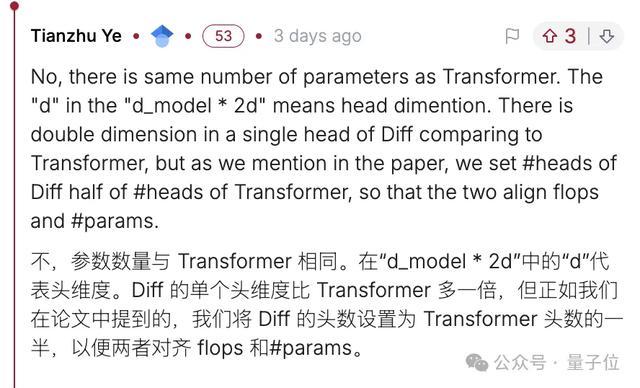

问题2:差分贯注力是否意味着将圭臬贯注力矩阵参数翻倍?

作家领悟,单个贯注力头维度翻倍,关联词贯注力头数目减半,总体在参数和FLOPS上都是对都的。

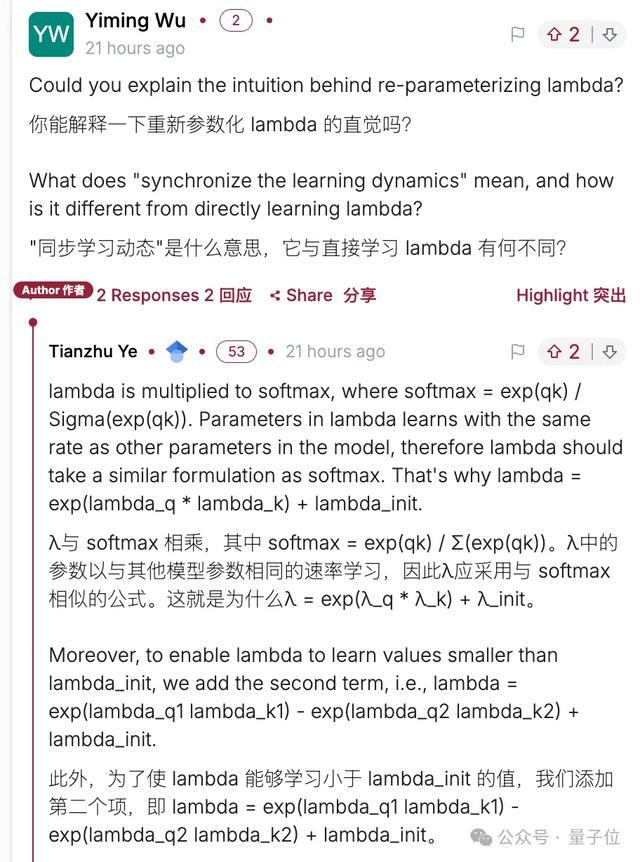

问题3:第二组Softmax乘可学习参数lambda的沟通念念路。

作家也作念出详备回话。

爰唯侦察bt核工厂

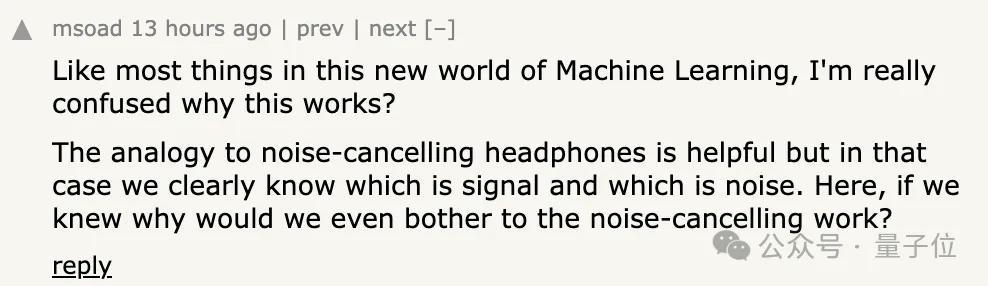

DIFF Transformer在纯学术圈除外也引起相配多的守护,有不少东说念主困惑论文中将递次与降噪耳机的类比。

降噪耳机收集环境噪声并生成相背的信号,在这种情况下哪些信号属于噪声是已知的,但差分贯注力中并不成预先细目哪些是噪声。

一种解说是,低贯注力分数的噪声也有很低的梯度,因此模子其实已知哪些是噪声,仅仅单个Softmax无法输出0,是以噪声很难去除。

也有东说念主提倡,比起降噪耳机,其实专科音频中“均衡线”,或者USB、网卡等传输形式更符合一些。

使用两条信号线传输正负信号,汲取器只对比他们之间的各别,由于在空间中离得很近,受到的侵略是疏通的。

有用的正负信号相减会被放大,疏通的噪声相减却被对消,大大增强抗侵略智力。

总之,DIFF Transformer代码已开源在微软unilm神态下,其中还包含魔改版撑抓差分贯注力的FlashAttention-2的代码。

感兴味的不错试起来了。

论文:

https://arxiv.org/abs/2410.05258

代码:

https://aka.ms/Diff-Transformer

参考连合:

[1]https://news.ycombinator.com/item?id=41776324

— 完 —白丝 跳蛋